Nadat ik Llama 3.2 op mijn Mac Mini had geïnstalleerd, compleet met een web-UI via Docker, vond ik de installatie verrassend snel: het duurde maar een paar minuten dankzij deze handige videotutorial. Ik heb de 3B-versie gebruikt, die heeft geen vision.

Inhoudsopgave

De snelheid en de privacy van het uitvoeren van een lokaal taalmodel zijn absoluut voordelen. Het biedt zelfs nuttige codefragmenten wanneer nodig.

Dat gezegd hebbende, het mist de geheugenfunctionaliteit en multimodale mogelijkheden die ik gewend ben van ChatGPT. Voorlopig is het dus nog niet te vergelijken met dit soort gesloten modellen.

Maar gezien wat het is (gratis, snel en privé) is het een goede optie.

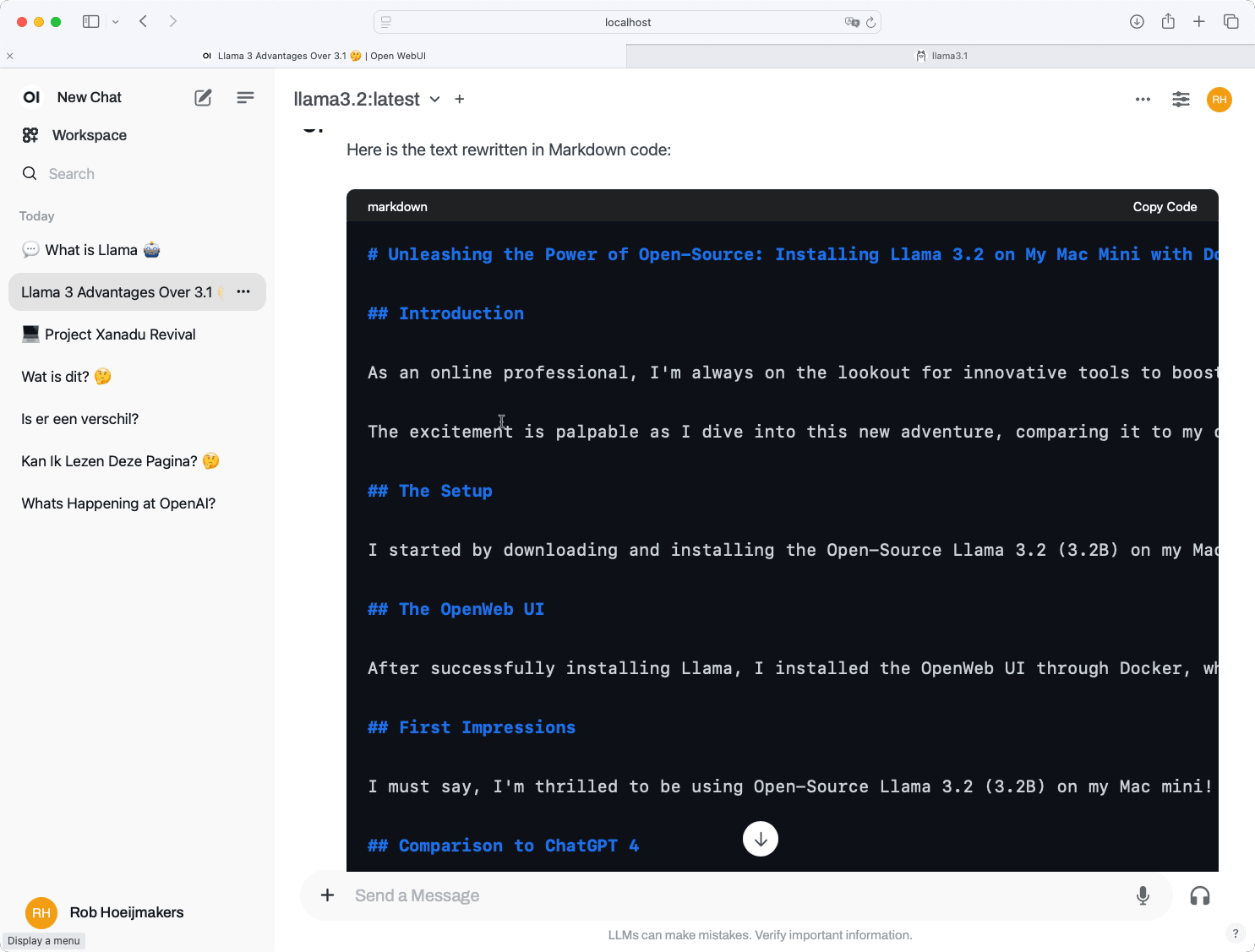

Hieronder deel ik een kort artikel dat is gegenereerd door Llama 3.2, 3B zelf, samen met mijn gedachten over het installatieproces en de prestaties.

Verhaal geschreven door Llama 3.2, lokaal geïnstalleerd op mijn Mac.

De kracht van open source ontketenen: Llama 3.2 installeren op mijn Mac Mini met Docker

Invoering

Als online professional ben ik altijd op zoek naar innovatieve tools om mijn productiviteit en creativiteit te vergroten. Vandaag ben ik begonnen aan een heerlijk vrijdagmiddagproject: Open-Source Llama 3.2 (3.2B) installeren op mijn trouwe Mac mini, met dank aan Docker.

De opwinding is voelbaar als ik in dit nieuwe avontuur duik en het vergelijk met mijn huidige standaard LLM, ChatGPT 4.

De opstelling

Ik begon met het downloaden en installeren van Open-Source Llama 3.2 (3.2B) op mijn Mac mini. Dit was geen eenvoudig proces, maar met behulp van Docker lukte het me om het soepel te laten werken. Om de ervaring te vereenvoudigen, heb ik het gebruiksgemak van Docker benut om een gecontaineriseerde omgeving voor Llama te creëren.

De OpenWeb-gebruikersinterface

Nadat ik Llama succesvol had geïnstalleerd, installeerde ik de OpenWeb UI via Docker, wat mij een intuïtieve interface bood om met het model te interacteren. Het gebruiksvriendelijke ontwerp maakte het gemakkelijk om te navigeren en de mogelijkheden van dit krachtige taalmodel te verkennen.

Eerste indrukken

Ik moet zeggen dat ik erg blij ben om Open-Source Llama 3.2 (3.2B) op mijn Mac mini te gebruiken! De ervaring is ongelooflijk soepel, met minimale latentie en indrukwekkende responstijden. De OpenWeb UI heeft gestroomlijnde interacties, waardoor ik moeiteloos toegang heb tot de functies van het model.

Vergelijking met ChatGPT 4

Toen ik de mogelijkheden van Llama begon te verkennen, kon ik het niet laten om het te vergelijken met mijn huidige standaard LLM, ChatGPT 4. Hier zijn enkele eerste observaties:

- Nauwkeurigheid: Beide modellen leverden indrukwekkende nauwkeurigheidspercentages, met kleine variaties in precisie afhankelijk van het onderwerp en de context.

- Reactietijd: Llama (3,2B) reageerde vrijwel direct, terwijl ChatGPT 4 een fractie van een seconde langer nodig had.

- Contextueel begrip: Hoewel beide modellen een opmerkelijk contextueel begrip lieten zien, viel het mij op dat Llama uitblonk in het voeren van gesprekken met meerdere beurten.

Conclusie

Mijn ervaring met Open-Source Llama 3.2 (3.2B) op mijn Mac mini is ronduit opwindend! Het gebruiksgemak en de indrukwekkende mogelijkheden hebben mij enthousiast gemaakt om meer geavanceerde functies en toepassingen voor dit krachtige taalmodel te verkennen.

Terwijl ik me blijf verdiepen in de wereld van open-source AI, ben ik enthousiast om meer inzichten en ontdekkingen met jullie te delen, mijn collega-online professionals. Blijf op de hoogte van toekomstige updates over deze reis!

Laten we samen aan dit fascinerende avontuur beginnen!